《The Selfish Ledger》会成为谷歌版的“新黑镜”吗?

2018年05月30日

评论数(0)

文 | 柯鸣

来源 | 智能相对论(aixdlun)

谷歌最近并不太平。

最近,谷歌两年前制作的一个仅供内部传发的视频被曝光,视频中提出了“Ledger”概念,Ledger收集用户所有数据,然后根据用户的行为、习惯等信息,引导用户完成一个目标。视频一曝光,引发舆论哗然的同时也让许多人再次陷入对于信息安全的深深担忧之中。

这部名为《The SelfishLedger》的短片,由谷歌 X 实验室设计负责人、Near Future Labortatory 联合创立人 Nick Foster 亲自操刀制作。在长达9分钟的视频中,Foster 定义了“Ledger(数据账本)”,并假设这些数据档案可以被建立,也可被用于修改行为以及进行用户之间的相互转移。

谷歌提出“全系统设置”概念

基于Ledger的概念,视频中谷歌提出了概念性的解决方案(conceptualResolutions by Google system)——提示用户选择一个生活的目标,在此后每次用户与手机的互动中,手机均会引导用户去实现这一目标。

谷歌认为其可以实现一个“有组织的价值观”,其包括用户在叫Uber出行时会建议用户使用拼车以及更加环保的出行方式,或者是引导用户从Safeway购买一些本地产品。

谷歌解决方案引导用户购买商品

实现这一切的前提,就是实现Ledger对更多数据的贪婪。它通过访问大量的用户数据和决策,对数据进行搜集和学习,进而提出建议。在未来,“以目标为导向的Ledger概念将变得更加可行,提出的建议可能不会由用户转化得出,而是由Ledger本身作出的”。

令人担忧的谷歌版“新黑镜”

一旦Ledger本身能够自主作出决断,这就让人细思极恐了。

Foster设想了一个未来:“目标驱动的Ledger概念变得容易被接受,并且行动建议可能不是由用户而是由Ledger本身提供的”,这就是《黑镜》描述的景象。而Ledger积极地寻求填补数据的空白,甚至选择购买它认为可以吸引用户的产品,以便采集数据。

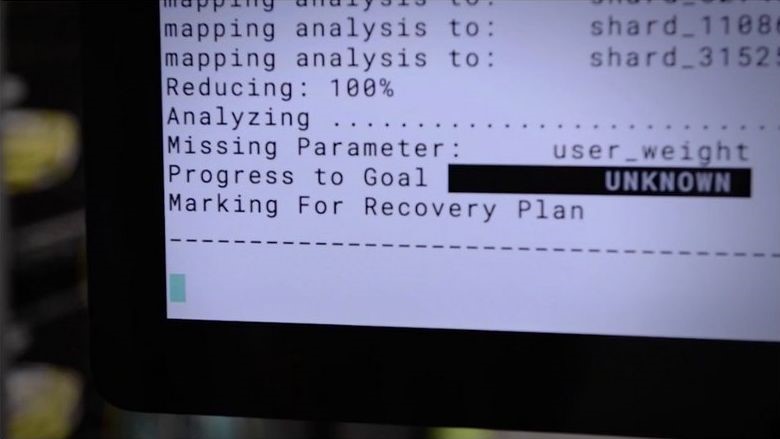

随后,视频中举了一个浴室体重秤的例子。一开始,Ledger 并不知道用户的体重。随后,视频画风开始趋向科幻情景,设想 Ledger 可能会变得十分精明,能够依靠3D打印技术打印自己的设计:“欢迎回家,Dave,我给你打印了一个体重秤。”

基于Foster对Ledger的构想,其如若照进现实,智能相对论(aixdlun)分析师柯鸣认为,这仍然存在着几个不容忽视的问题。

1.恐成控制大众的反乌托邦视野

Foster对Ledger的构想并不仅仅是一个自我提升的工具。这个系统还能够“填补知识空白”、“改进人类的行为模型”,这不仅仅包括你我的特定行为,更包含着整个人类的群体行为。虽然视频指出试图通过使用思想控制技术来解决贫困和全球变暖等问题,但视频认真讨论在全球范围内大规模行为改变的事实是令人恐惧的。

工智能之父马文·明斯基认为“大脑不过是肉做的机器”,而人类思维是一个复杂的过程。比如“为什么人类下雨不想被淋湿,却愿意在卫生间沐浴”这种3岁小孩都知道的问题,计算机就会感到费解。

对于用户而言,Ledger的预期设计让大家感到隐忧。一位X的发言人说明道:这是多年前设计团队的一个思想实验,他们使用一种被称为“推测设计(speculative design)”的技术来探索让人不舒服的想法和概念,从而引发讨论和辩论。它与任何当前或未来的产品无关。

但其实,早在2015年谷歌所提交的专利申请中,就有存在“检测和纠正用户行为中的潜在错误”的提法,这与Ledger的功能十分相似。当其真正普及于人类生活之中,其依然是让人恐慌的。

2.信息伦理问题再上风口浪尖

“想要得到多少便利,在于你愿意放弃多少信息隐私”,这好像已经成为诸多谷歌类公司的永恒二分法。信息伦理随着Ledger以及亚马逊Alexa再爆将私人对话发给同事的事故时,其再次成为人们关注的热点。

而此种事件,早已不是个例。早前Facebook被指控利用个人信息系统,预测和影响选民的政治倾向,扎克尔伯格对此承诺将进行严厉整改,并表示将专门成立人工智能伦理团队来保障信息安全问题。

其实在大卫·惠特克事件中,谷歌早就存在着信息泄露的问题。谷歌主宰着用户的信息获取,而依靠这种垄断性的力量,谷歌在早年的时候也用竞价排名的方式来推广一些不良、虚假信息。2009年便发生了美国政府假装在谷歌上贩卖假药并得以推广的丑闻事件。

此后的“棱镜门”事件,以及通过人为操作搜索词,干涉美国大选等问题,依然是借用信息资源而进行的不良行为。

“不再作恶”的谷歌

不太平的事情还有一件。

近日谷歌在其最新的行为准则中,将“不作恶”的文本已经几乎彻底删除,虽然2015年谷歌重组并将Alphabet作为母公司时,该公司几乎完全放弃了“不作恶”的口号,改为了“做正确的事”。

修改后的谷歌准则

同时,谷歌已有十几名员工正式请辞,以抗议公司继续参与军方的Maven项目。此外,学术界有364名人工智能专业人士也联名上书,反对谷歌。为表示抗议,先是有近4000名谷歌员工联署请愿书,之后约12名谷歌员工向公司辞职。

这些辞职的员工对将人工智能运用在无人机作战感到担忧,同时也担心谷歌的政治决策,这些都可能导致用户对谷歌的信任被削弱。虽然谷歌强调,它的人工智能技术不会被用来杀戮,但也承认把人工智能运用在五角大楼的无人机项目中,会为技术工作者和研究人员带来伦理和道德问题。

抛开谷歌本身而言,人工智能从通用AI(General AI)发展到“心智社会”后,智能相对论(aixdlun)分析师柯鸣认为其依然有着许多“恐怖之处”。

1.对社会优先问题错位的恐惧

目前,机器人已经取代了部分体力劳动。用不了多久,它们便可胜任一度被认为只有人类才能完成的认知工作。自动驾驶汽车将取代出租车司机;自动驾驶飞机将取代飞行员。

也许有朝一日,所有人类工作都将被机器取代。我们所有的工作也可能被许多速度更快、不知疲倦的机器代替,由它们来生产更多更迅速的内容产品。

在现代社会中,自动化导致许多人失业。机器所有者变得愈发富有,其他人则愈发贫穷。这并不是科学问题,而是政治和社会经济问题。

诚然,若依靠AI做恶是有违科学家的初衷的,毕竟技术知识手段和工具,其真正的好坏在于使用它的人。在技术和人类面前,人类本身的安全性、稳定性是第一位的,机器优先、智能优先的社会错位只会加深人们的不安定感和恐惧感。

2.对滥用的恐惧

从 1920 年的戏剧《R.U.R.》中愤怒的机器人到《2001:太空漫游》中的杀人计算机 HAL9000,人工智能的发展总是伴随着暗黑的神话。人工智能对人类很多好处。其中一些已经实现,比如搜索引擎和机器翻译;另一些则即将实现,比如自动驾驶汽车。但是,随着人工智能能力的增长,使用的便捷性更容易促进滥用的产生,而AI的滥用无疑是让人恐惧的。

近日一份由25名技术人员与公共政策研究员共同发布的报告指出,随着人工智能的发展,被恶意利用的风险也呈上升趋势。报告中还称,一旦人工智能遭到了黑客攻击,将增加诸如无人驾驶车祸,商业无人机变成针对性武器的可能性。

诚然,恶意使用人工智能会对数字、物理和政治安全造成迫在眉睫的威胁,因为它可能被利用来实施大规模的、极具针对性的高效攻击。 而在去年底,一个色情视频流传到网上,一些名人的面孔经过智能抠图,被嫁接到了不同身体上,甚至有些影片可以以假乱真,因此导致了很多明星名誉受损。

如今人工智能的发展可谓是突飞猛进,很多曾经看似不可能实现的事情,现在已经变成了可能。然而服务于人类的人工智能如果被不法分子运用,那将会带来灾难性的后果。

总结

从爆出《TheSelfish Ledger》短片到删除“不作恶”的准则,谷歌的人工智能领域确为多事之秋。但是,不可否认的是,技术的进步与革新带来的是整个行业的发展。《The Selfish Ledger》是否会成为谷歌版的“新黑镜”,这还需要时间和市场来检验,而谷歌本身的发展,依然需要辩证的来看待。

智能相对论(微信id:aixdlun):深挖人工智能这口井,评出咸淡,讲出黑白,道出深浅。重点关注领域:AI+医疗、机器人、智能驾驶、AI+硬件、物联网、AI+金融、AI+安全、AR/VR、开发者以及背后的芯片、算法、人机交互等。